Character as an Interface: XR HMDにおける汎用UIの実験プロジェクト

XR領域は未だ発展の途上にあり、2021年現在Oculusを中心にいくつかのプラットフォームや、それを土台にしたコンテンツが生まれてきているものの、コンテンツやこれからのサービスのUI/UXは未だ決定版というには程遠い状況にあります。今回S.C.L.の企画によって結成された3人のメンバーによるプロジェクトとして、MagicLeapを活用した、AR HMDのUI/UX研究開発を行いました。

本ページではプロジェクトの概要を、そこへ至ったリサーチ・開発ログと合わせて公開します。

| 動作環境 | Magic Leap、Oculus Quest(予定) |

| ジャンル | XR UI |

| 発表形態 | 展示発表+GithubにてOSS公開(予定) |

How to PLAY?

*Oculus Quest対応OSSは現在公開準備を進めています。

2つのUIシステムをMagic Leap対応でGithub公開しました!

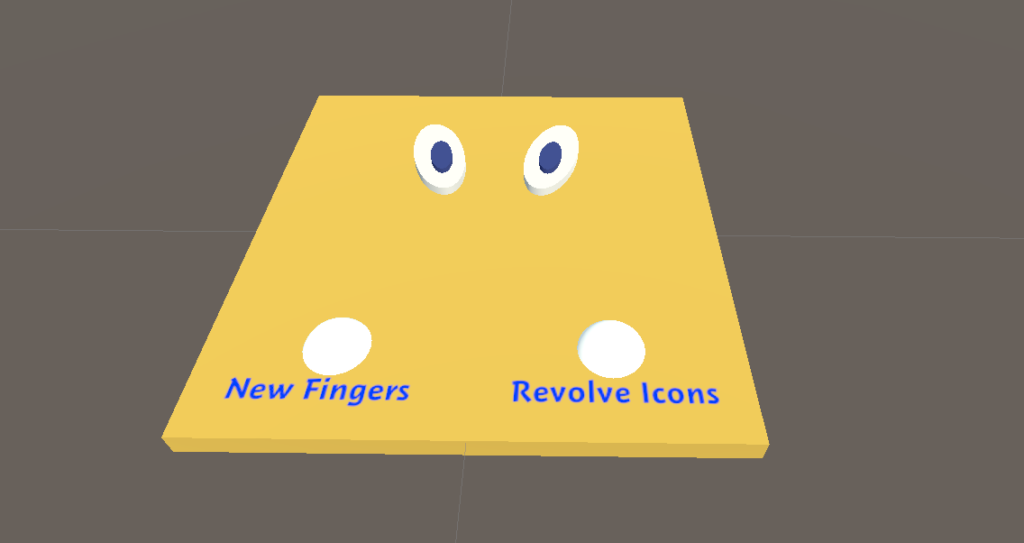

RevolveIconsとNewFingersの2つの機能を扱いやすいUnityPackageを含んだOSSとしてリファクタリングし、公開しました!

▼実装された3つのプロジェクト

Everywhere Pad

「どこでも、なんでも、それはコントローラー」

あらゆる平面を即席のコントローラーとして利用するUIを提案します。現実の物理的な平面を利用してそこに情報や操作系を配置することで、ボタンを押すなどの操作に触覚的フィードバックを創出し、操作感を飛躍的に向上させます。*現在はマーカーを読むことで平面を認識し、コントローラーを出現させるプロトタイプです。将来的には平面を検出し、何かしらのジェスチャーによって、あらゆる平面をコントローラーとして扱うことをビジョンに想定しています。

REVOLVE ICONS

「クールなUIは、クールなジェスチャーで。」

大振りなジェスチャーでいくつかのリストから一つのものを選択します。

複数のものから一つを選択するための動作として、腕の場所や動作の精密性にある程度の融通を効かせ、大振りな操作で実現させます。

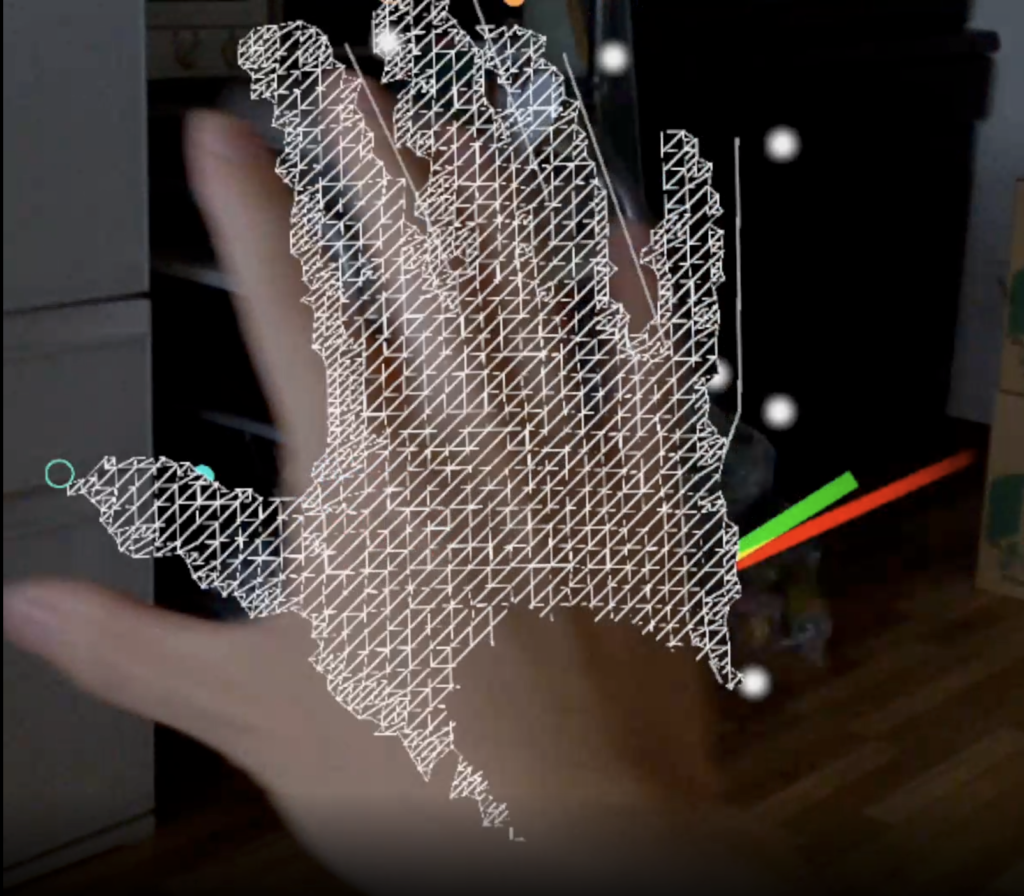

New Fingers

「21世紀、指は次のステージへ。」

これまでお世話になってきたマウスのように、指のジェスチャーによってあらゆる場面で「決定・メニュー・進む・戻る(あるいはショートカットの登録)」を行うことができる汎用的なXR操作を提案します。

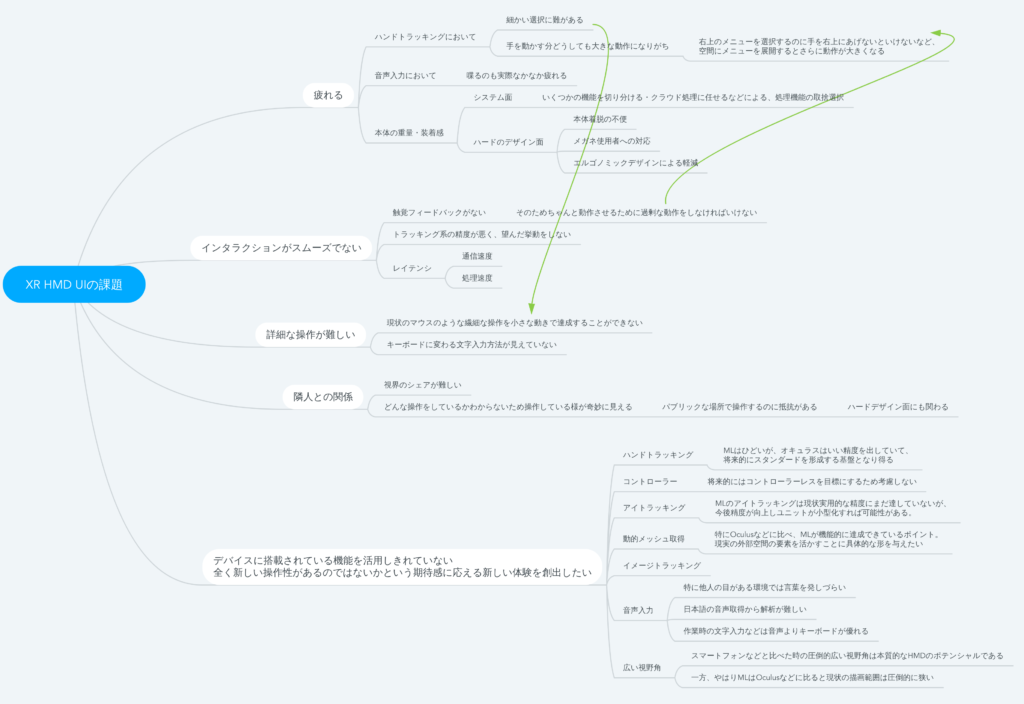

RESEARCH

リサーチの流れ

現状の課題分析→今回のプロジェクトで扱う具体的範囲の抽出→具体的なプロジェクトの形に落としこむ

前提

「5年後、10年後に、今のスマートフォンに代わるデバイスとして、AR HMDがつかわれる日常のUI/UXを考える」

RESEARCH結論:取り組み範囲の抽出

実際には音声入力や動的メッシュ生成などそれぞれの技術も試しつつ、最終的には下記の要素を今回のプロジェクトで実装していくポイントとして決定した。

- ハンドトラッキングの「細かい選択への難」、「手を動かす分大きな動作になる」ために操作に疲れてしまう点

- 触覚フィードバックがない点

これが解決されていくことによって、ARデバイスが日常化していく未来のビジョンに、より明確な人間の姿を与えていくことができると考えている。

開発ログ

6月中旬までに大まかな方向性とチームを決定。MagicLeapをハードウェアとしてメインに使用していくことに。

Unityにて環境構築。2週間に1度全体MTGで進捗を発表しながら開発を進行。

実のところ初めはどちらかと言えばコンテンツ寄りのプロジェクトで始まったが、さまざまな仕様の把握に伴い、UI/UX研究開発をメインテーマに、プロジェクトをピボット。現在の形へ。

またそのタイミングでSCL外部の方へのヒアリングの機会を設け、UI/UXの視点からフィードバックをもらい、開発を進める。

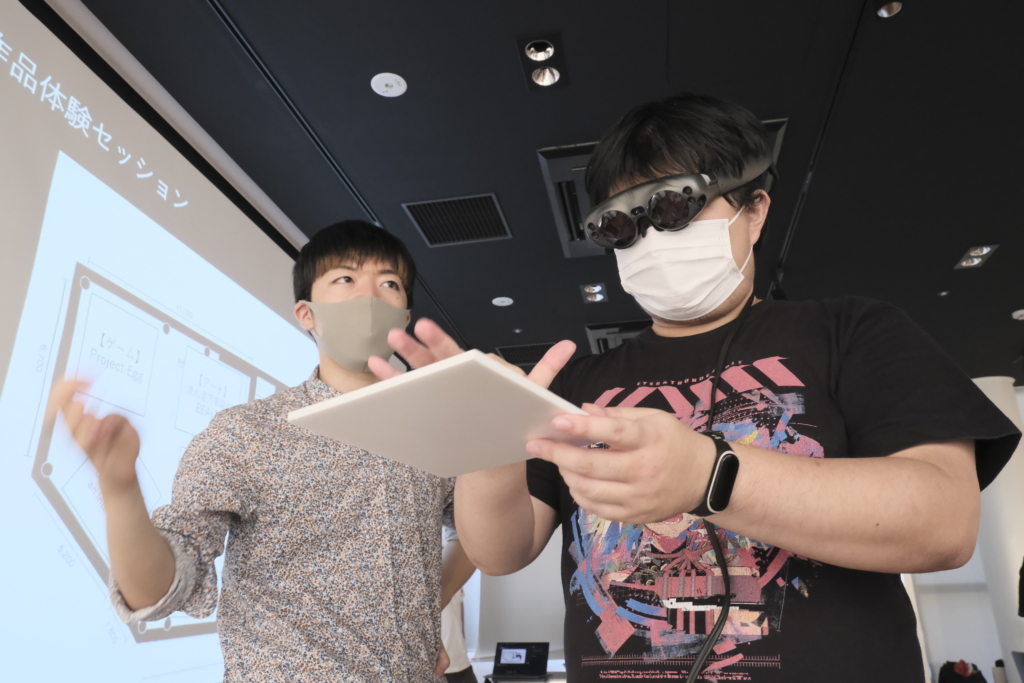

実際の展示場にてSCL内部、また数名のゲストを招き、展示発表。展示体験ならではのフィードバックを得て、外部発表に向けた最終形態へ調整。

展示ならではのフィードバック

開発は3つの機能それぞれを独立して主に進め、展示に向けて組み立てる、という手法をとっていたために、いくつかの機能どちらもアクティブである時の状況への意識が、開発時点では足りていなかった。

この時点での体験ストーリーは、それぞれの機能を持った3つのキャラクターを、アイトラッキングによってアクティベイトして、各機能を体験するようになっていたが、実際にそれを展示に落とし込んだ時に、アイトラッキングと他の操作系との切り分けが明瞭でなく、どうしたらどうなるといった明確なインタラクションをデザインできていなかった。XRのUIを考えていくに当たっては、他のUIや操作系も同時に存在する可能性について、しっかり考慮する必要があった。

●最終的な各プロジェクトの概要・ポイント

- ・Everywhere Pad

-

Everywhere Padは、平面にボタンや情報が表示され、それを手で操作することで、さまざまなインプットを可能にするAR UI。

板に指が触れるため、操作に触覚フィードバックが設けられる点、特定のモノに結びついているため操作系をあるモジュールに完結させられる点にコミットしている。今回はボードを用意し、このイメージを登録することによって、イメージトラッキングで操作系を表示させている。

- ・Revolve Icons

-

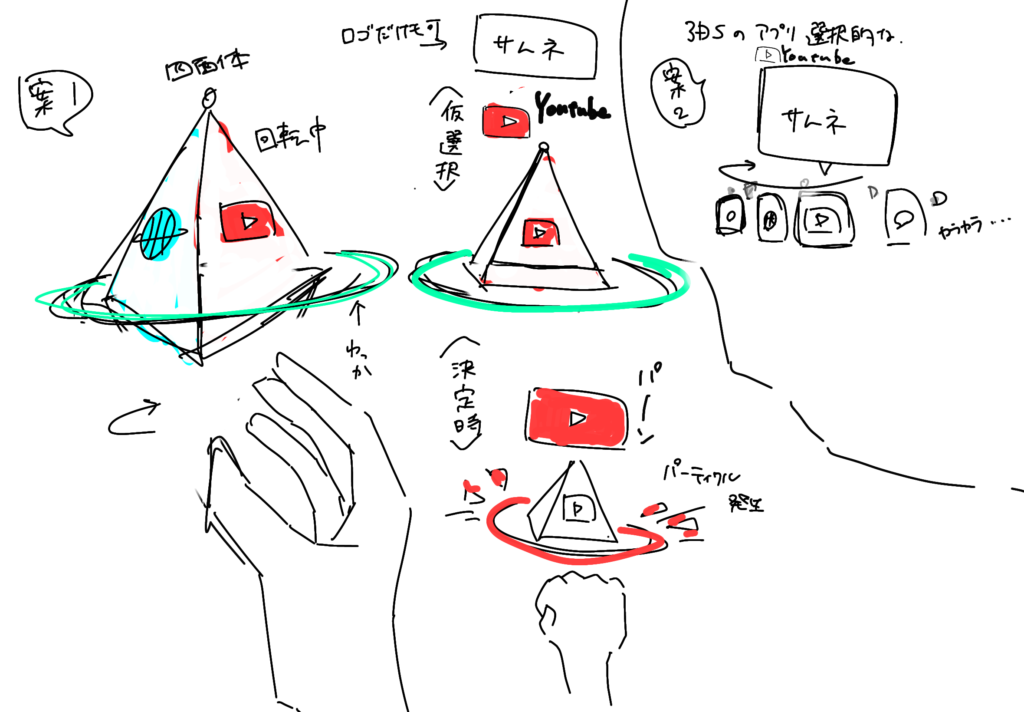

Revolve Iconsは複数のリストから一つのものを選択するためのXR UI。手を広げることによって手元にリストが現れ、手を回転させることで選択を任意のものへ推移させ、手を握ることでそれを選択するという流れになっている。

大振りなアクションで、腕を置く位置に自由度を持たせることで、ハンドトラッキングで疲れてしまう点、煩雑性、またいけてるジェスチャーにすることで、外からの視線への意識を緩和することにコミットしている。

- ・New Fingers

-

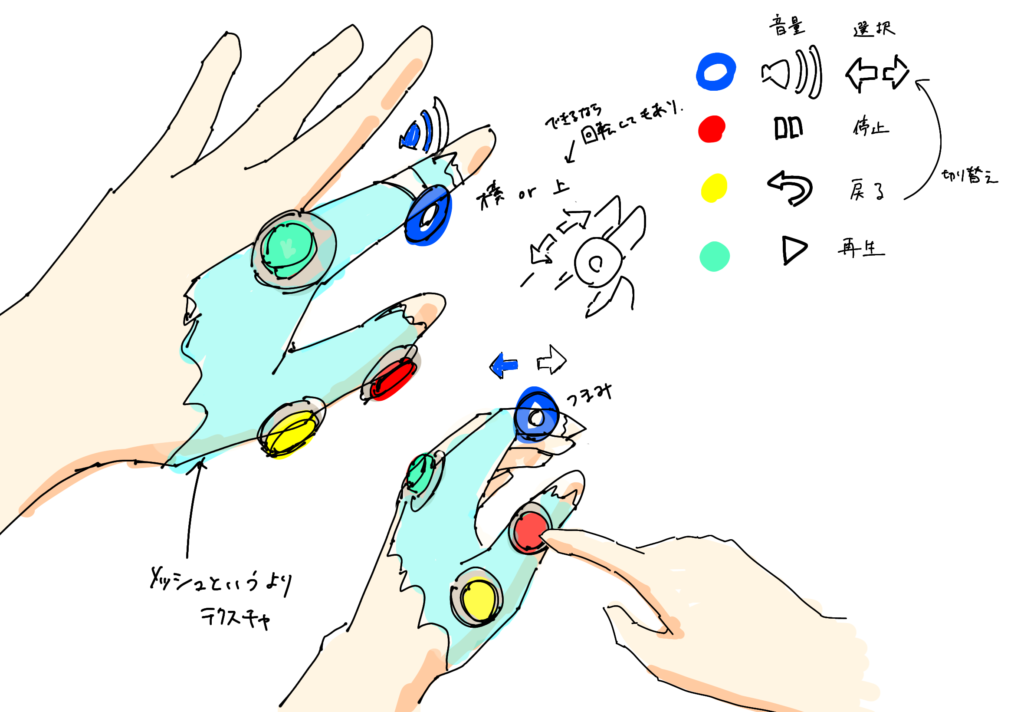

New Fingersは右手のジェスチャーによっていくつかの操作を可能にするXR UI。親指がどの指に触れるかによって、どの操作を呼び出すか紐づくようになっている。従来のマウスを参考に、親指と人差し指であれば選択(左クリック)、親指と中指であればメニュー(右クリック)、薬指と、薬指の付け根(小指よりも薬指の付け根の方がアクセスが良い)には戻る、進む(あるいは任意のショートカット)が可能になっている。

従来のUIに比べ手の位置に自由度を持たせ、またミニマムな操作性を実現することでハンドトラッキングで疲れてしまう点にコミットしている。またそれぞれの操作はそれができたことを触覚的に感じられる点も重要である。

これまでのPC操作においてのマウスの功績を意識し、ミニマムで繊細で堅牢であり、全ての操作のベースの地位を築いていることを目指している。

展示にあたっては、Everywhere Padは他のプロジェクトと競合しづらいため、Everywhere Padによって他2つのプロジェクトをそれぞれアクティベイトして体験できる形に落とし込んだ。

まとめ

- 今回はピボットや取捨選択を経て、完成度はデバイスの制約も含めてまだまだながら、コンセプトとしては粘り強く本質的に価値のある部分にアプローチできたと感じている。特にNew Fingersは、次世代のスタンダードを取れる可能性のある、実はかなり野心的なプロジェクトとして実感を得ている。ぜひOSS公開を達成した際は、世界のあらゆる開発者に吟味してもらい、この可能性を伸ばしていってほしい。

おまけ1:最終的な形態以外の部分でコミットし、見えたこと

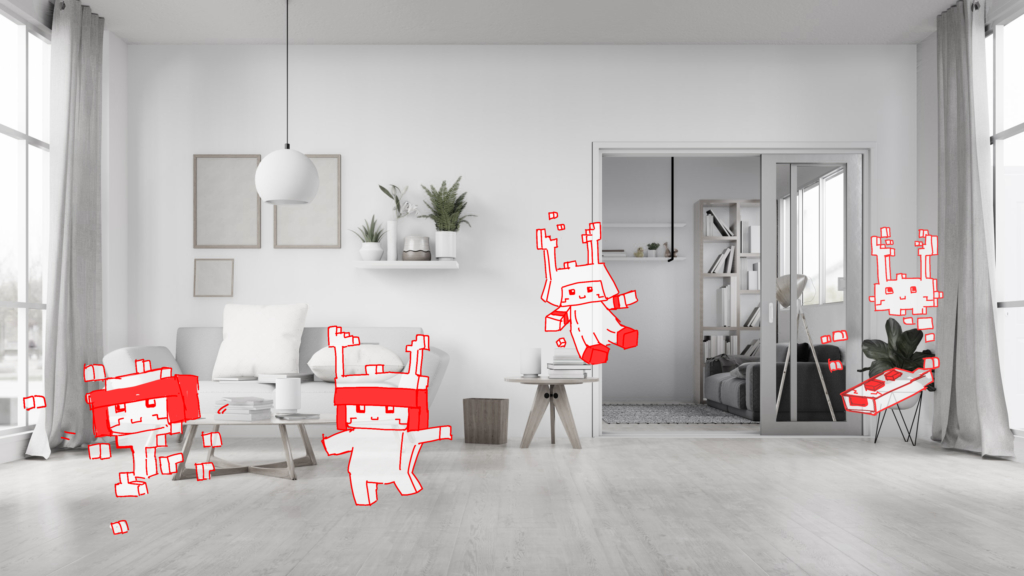

- 物理空間とのインタラクション:奇妙なことをしているプレーヤーのボディへの視線への配慮として、「Siriにボディを与える」というアイデアで、現実空間の中を動き回るキャラクターAIの作成にトライしたが、物理空間を動的に取得するのに過度な信用は難しいと感じた。具体的には、取得できていない場所にAIが差し掛かると床をすり抜けて落ちてしまったり、床に物が置いてあるだけで自動移動ができなかったり、狭い場所や座っている体制の時に壁にめり込まずに近くに来てもらうのが非常に難しいなど、現実のさまざまな変数に対応するのが非常に難しく、あえて挑戦すべきではないという結論になった。現実の物理空間との組み合わせは、壁や床や机を一時的に検知して何かを表示させる、など限定的な用法で変数の影響を抑える工夫が重要だと考えている。壁にバーチャルオブジェクトがめり込むことはあまりネガティブに捉える必要はなく、3次元の現実空間に、もう一つ違う次元の空間が張り付いていて、AR HMDからはそれを知覚することができる、そういった概念で扱えるといいのではないかと思う。

- それに関わり、現実空間とバーチャルオブジェクトはレンダリングというか、見え方が根本的に異なるため、現実空間のオブジェクトでバーチャルオブジェクトをオクルージョンすることが、全く効果的に見えない。ちょっとした輪郭のずれや、ワールドのバーチャルオブジェクトの存在を検知できなくなる問題と含め、課題が大きい。もしオクルージョンに拘るなら、壁に埋まると半透明になったりワイヤーフレーム表示するなどで、完全に消さない方法でビジュアライズできるといい効果が得られるかもしれない。総じて、デバイス側がカタログスペック的に「可能」であることが、本質的にその意義を発揮しているかはプロジェクトごとに精査していく必要がある。

- 音声入力:MLのマイク取得から、まずは文字起こしにトライしたが、API叩いてもなかなか難しかった。この次のステップに自然言語処理が待っていることを考慮し、Googleには勝てないという判断で今回はパスした。GoogleAssistantのAPIを使うなどでトライできると可能性はあると思う。

おまけ2:開発で見えたMagic Leapの課題(いくらかは愚痴)

- XR開発の現状は、やはりまだあらゆる意味でスタンダードが決まっておらず、新しいデバイスが出るたびに新しいことが可能になっているようであっても、実際に開発してみると実用レベルに達していないという部分が数多くあった。今回はその中でも将来性のある部分をプロジェクトとして開発していったと考えているが、その途中でピボットや、取捨選択した機能も多かった。今後もXRの開発には、そういった部分が必ずあることもスケジュールに入れる必要がある。以下は今回直面したMagic Leapの具体例。

- 安定感がない。開発時のイテレーションも通ったり通らなかったりし、再起動することで直ったり治らなかったりする。バージョンなど揃えても、デバイスを変えるとアイトラッキングが動かないといったような事態も頻発し、開発コストが高い。

- デバイスのハードデザインも悪く、装着しづらさや、ケーブルの取り回しの悪さも開発コストを上げている。

- 視野角が狭い

- 最短表示距離が長い。オブジェクトから目までの距離が40cmくらい以内で見えなくなってしまう。つまり、近くのものがほとんど見えない。

- ハンドトラッキングの精度が低い。MagicLeapのハンドトラッキングの精度はプロトタイプと言わざるを得ない。手が重なった状況や、少し複雑なジェスチャーをした時に使用に耐えるものでは無い。ちなみにハンドトラッキングの精度で言えば、Oculusの方はとてもよくできている。

- アイトラッキングの精度が低い。視野角の端の方ほど全然取れなくなる。また、デバイスでキャリブレーションをしないと個人差によってこれもまた精度低下の原因になる。

MEMBER

Director

林裕人 |

Yuto Hayashi

東京藝大メディア映像研究科M1, WOGO.Inc UI/UXデザイナー

web: hyasssy.tokyo

Twitter: @hyasssy